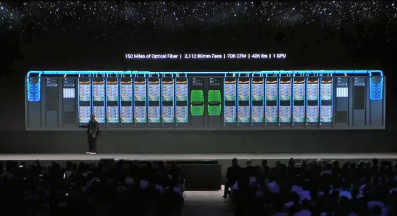

Nvidia CEO 黄仁勋在台北 Computex 2023 上宣布,该公司的 Grace Hopper 超级芯片现已全面投产,Grace 平台现已赢得六项超级计算机大奖。这些芯片是 Huang 在 Computex 2023 上发布的其他重大公告之一的基本组成部分:该公司全新的 DGX GH200 AI 超级计算平台专为大规模生成式 AI 工作负载而构建,现在可与 256 个 Grace Hopper Superchips 配对,形成一个 144TB 的超级计算引擎用于最苛刻的生成 AI 训练任务的共享内存。Nvidia 已经有像谷歌、Meta 和微软这样的客户准备好接收最先进的系统。

Nvidia 还宣布了其新的 MGX 参考架构,该架构将帮助原始设备制造商更快地构建新的 AI 超级计算机,最多可提供 100 多个系统。最后,该公司还发布了专门为 AI 服务器和超级计算集群设计和优化的全新 Spectrum-X 以太网网络平台。让我们开始吧。

我们过去曾深入介绍过Grace和Grace Hopper Superchips 。这些芯片是 Nidia 今天宣布的新系统的核心。Grace 芯片是 Nvidia 自己的 Arm CPU-only 处理器,而 Grace Hopper Superchip 在同一个封装中结合了 Grace 72 核 CPU、Hopper GPU、96GB HBM3 和 512GB LPDDR5X,全部重量为 2000 亿个晶体管. 这种组合在 CPU 和 GPU 之间提供了惊人的数据带宽,CPU 和 GPU 之间的吞吐量高达 1 TB/s,为某些内存受限的工作负载提供了巨大的优势。

随着 Grace Hopper Superchips 现已全面投产,我们可以预期系统将来自 Nidia 的众多系统合作伙伴,例如 Asus、Gigabyte、ASRock Rack 和 Pegatron。更重要的是,Nvidia 正在推出基于新芯片的自己的系统,并发布了 OxM 和超大规模处理器的参考设计架构,我们将在下面介绍。

Nvidia 的 DGX 系统是其用于要求最苛刻的 AI 和 HPC 工作负载的首选系统和参考架构,但当前的 DGX A100 系统仅限于八个 A100 GPU 作为一个整体单元串联工作。鉴于生成式 AI 的爆炸式增长,Nvidia 的客户渴望拥有性能更高的更大系统,而 DGX H200 旨在为最大工作负载(如生成式 AI 训练、大型语言模型、推荐器)提供大规模可扩展性的终极吞吐量系统和数据分析,通过使用 Nvidia 的定制 NVLink 交换机芯片来回避标准集群连接选项(如 InfiniBand 和以太网)的限制。

关于新型 DGX GH200 AI 超级计算机更精细方面的细节仍然很少,但我们知道 Nvidia 使用带有 36 个 NVLink 开关的新型 NVLink 开关系统将 256 个 GH200 Grace Hopper 芯片和 144 TB 共享内存连接到一个内聚单元中看起来和操作起来都像一个巨大的 GPU。新的 NVLink 开关系统基于其现已进入第三代的NVLink 开关芯片。

新传媒网

新传媒网